一家开发具有AI功能的社交媒体移动游戏平台的创业公司Artie今天发布了用于检测语音应用中的人口统计偏差的数据集和工具。Artie Bias语料库(ABC)由音频文件及其转录组成,旨在诊断和减轻语音识别系统中年龄,性别和口音等因素的影响。

自从IBM的Shoebox机器和Worlds of Wonder的Julie玩偶以来,语音识别已经走了很长一段路。但是,尽管AI取得了进步,但当今的语音识别系统充其量是不完善的,而歧视性则是最差的。在《华盛顿邮报》委托进行的一项研究中,与本地出生的用户相比,由谷歌和亚马逊制造的流行的智能扬声器了解非美国口音的可能性要低30%。最近,算法正义联盟的语音擦除项目发现,来自苹果,亚马逊,谷歌,IBM和微软的语音识别系统总体上实现了非裔美国人语音35%的单词错误率,白人语音19%的单词错误率。

Artie发布了用于测量语音识别模型偏差的工具

Artie Bias语料库是Mozilla通用语音语料库的精选子集,代表三种性别等级,八个年龄段(从18到80)和英语中的17种不同的口音。除了2.4个小时的音频(1,712个单独的剪辑)和转录在Common Voice网络平台和母语专家上进行的投票表决之外,它还包含有关发言人的自我识别的,参与的人口统计数据。

作为概念证明,Artie研究人员将Artie Bias语料库应用于Mozilla的开源DeepSpeech模型,该模型在至少一个已知对北美英语有偏见的语料库上进行了训练。在另一个实验中,他们在公开可用的Google和亚马逊美国英语模型中评估了性别偏见。

根据研究人员的说法,DeepSpeech确实表现出对美国和英国口音的偏见,但没有性别偏见。另一方面,截至2019年12月上旬,与Amazon Transcribe的美国英语模式相比,谷歌的美国英语模式显示出“统计学上显着”的性别偏见,女性说话者的平均表现差了6.4%。

Google发言人对VentureBeat表示:“公平是我们的核心AI原则之一,我们致力于在这一领域取得进步。”这样做。去年,我们开发了工具和数据集,以帮助识别和消除机器学习模型中的偏见,并且将它们作为更广泛社区的开源。”

“随着语音技术变得越来越普遍,我们发现它有多脆弱……在某些情况下,人口统计学偏差会使某人因为其人口统计学而无法使用该技术,” Artie首席科学家兼Mozilla研究员Josh Meyer写道。在博客文章中。“即使对于资源丰富的语言(例如英语),最先进的语音识别器也无法可靠地理解所有本地口音,而且他们通常比男人更能理解男人……解决方案是面对问题,并努力寻求解决方案。”

NBA2K如何将下一代体育迷和品

Mashroom的端到端租赁和物业

边缘的AI正在推动无缺陷工厂

AnaloguePocket预购将于8月3

吃豆人工作室使您可以在Twit

HuaweiMateXs的发布日期与价

这种芯片可以在几秒钟内下载

DeanBeat表示数字游戏活动并

声破天现在显示印度最受欢迎

演示与300mmSiCMOS技术兼容的

极品飞车热火不会再有战利品

印度的Byju公司以3亿美元的价

Startup推出创新产品每天向亚

三星将在即将举行的GalaxyNo

Instagram现在可让您通过布局

研究人员提出了使用合成面孔

Twitch为Mac用户推出了自己的

YCombinator演示日将保持虚拟

Netflix将开始取消长期休眠订

NetApp收购Spot以获取云基础

苹果的带无线充电盒的AirPod

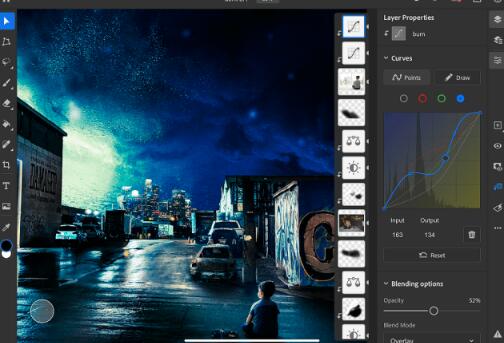

iPad的Photoshop获取曲线和A

Snap推出为期13周的远程计划

SteamCloudPlay进入测试版并